| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 | 29 |

| 30 |

Tags

- SQL공부

- 코세라강의

- 경제공부

- sql

- WHERE

- 코세라머신러닝

- mysql

- 머신러닝강의

- groupby

- PYTHON

- 머신러닝

- 프로그래머스SQL

- 코세라

- DATE_FORMAT

- coursera

- orderby

- Andrew NG

- Machine Learning

- sql오답노트

- sorted

- 코세라머신러닝강의

- 파이썬

- programmers

- 인프런sql강의

- Algorithm

- POP

- 알고리즘

- 안드류응

- map

- 프로그래머스

Archives

- Today

- Total

미래를 예측하는 데이터분석가

[Coursera] 머신러닝 Andrew Ng 강의 3주차 정리노트 - 2 본문

Machine Learning by professor Andrew Ng in Coursera

Day 7 - Logistic Regression Model

Cost Function

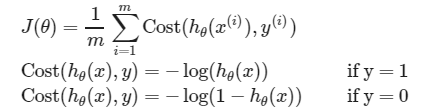

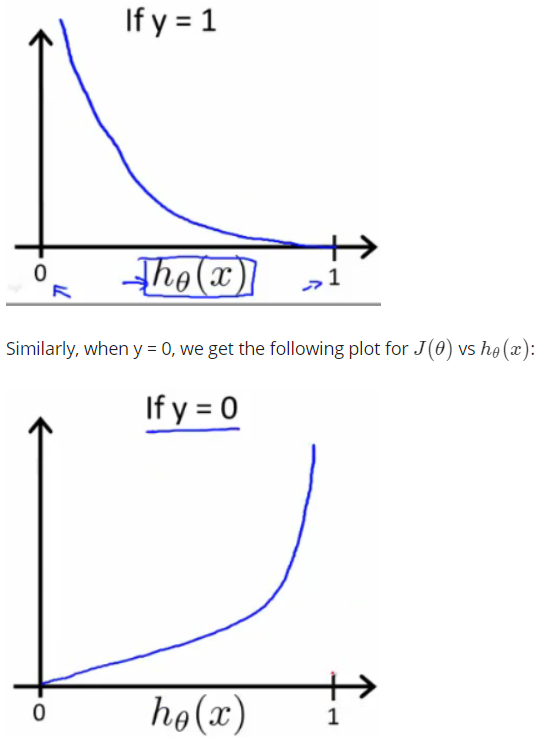

선형함수인경우와 다르게 비선형함수인 Logistic Regression의 경우에 Cost Function 그래프로 non-convex형태가 되어 global Minimum을 그래프가 울퉁불퉁해 찾을 수 없게 됩니다. 그래서 선을 smooth하게 바꿔주기위해 Cost Function을 다음과 같이 새로 정의하게 됩니다.

위 그림과 같이 y=0과 y=1일 때 그래프를 그리면 다음과 같습니다. 예측값이 1인데 실제값이 0이고 예측값이 0인데 실제값이 1이면 Cost Function은 무한대로 발산하게 됩니다.

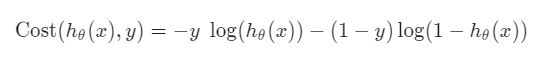

Simplified Cost Function and Gradient Descent

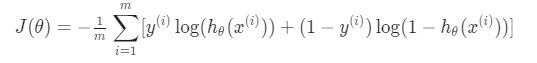

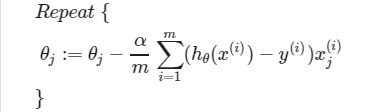

위의 Cost Function식을 합치면 다음과 같이 표기할 수 있습니다. 하지만 우리가 찾고 있는 것은 비용함수를 가장 작게하는 파라미터값을 찾아주는 것이 목적입니다. 그래서 iteration을 하였을 때 식으로 표기하면 다음과 같습니다.

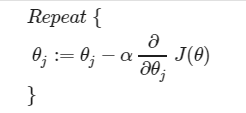

그리고 Gradient Descent 알고리즘을 적용시켜 비용함수가 작은 파라미터 값으로 계속해서 갱신해줍니다.

정리하자면 위와 같이 표현할 수 있습니다.

Advanced Optimization

Conjugate Gradient, BFGS, L-BFGS는 그레디언트보다 훨씬 정교하고 빠른 방법들 중 하나입니다. 하지만 Computing전문가가 아니라면 쓰는 것을 권장하지 않습니다. 대신 다른 사람들이 이미 테스트하고 이용해왔던 것들을 사용하는게 좋은데 그러한 방법중 Octave 프로그램을 사용하는 것입니다.

'강의노트 > Coursera' 카테고리의 다른 글

| [Coursera] 머신러닝 Andrew Ng 강의 3주차 정리노트 - 4 (0) | 2021.02.17 |

|---|---|

| [Coursera] 머신러닝 Andrew Ng 강의 3주차 정리노트 - 3 (0) | 2021.02.16 |

| [Coursera] 머신러닝 Andrew Ng 강의 3주차 정리노트 - 1 (0) | 2021.02.13 |

| 코세라 머신러닝 Octave 설치 및 과제 제출 (0) | 2021.02.12 |

| [Coursera] 머신러닝 Andrew Ng 강의 2주차 정리노트 - 2 (0) | 2021.02.08 |